Теория нейронных сетей. Урок 10.

Алгоритм обучения многослойного персептрона для чайниковЧто бы смотреть урок полностью, подпишитесь на платный раздел.

В платном разделе статья находиться здесь.

Об обучении многослойного персептрона я уже писал в статье "Теория нейронных сетей. Урок 6. Многослойный персептрон". Однако, там присутствуют довольно сложные математические выкладки. Поэтому я поднимаю эту тему еще раз, на это раз тоже самое, но "по русский", то есть, на понятном языке.

Что бы обучить нейросеть, нам нужны тренировочные набор данных. Тренировочные данные состоят из образцов входных сигналов (x1 и x2), связанных с целевыми (желаемыми)выходными сигналами z. Обучение нейросети это многоступенчатый процесс. На каждой итерации весовые коэффициенты узлов изменяются в соответствии с новыми данными обучающего набора данных. Модификация рассчитывается алгоритмом, описанном ниже:

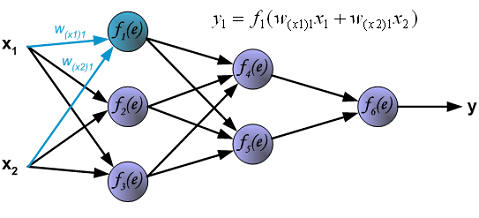

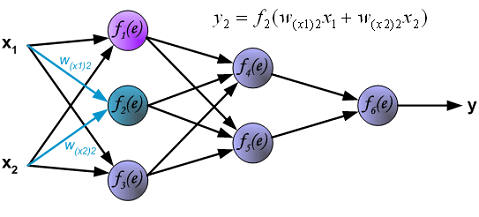

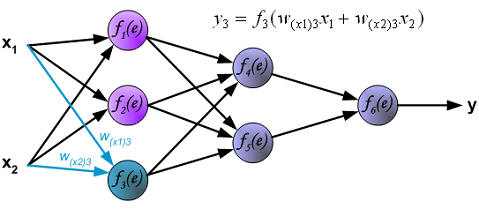

Каждый шаг обучения начинается с поступления на входы сигналов с обучающего множества. После этого этапа можно определить значения выходных сигналов для каждого нейрона в каждом слое сети. Картинки ниже показывают, как сигналы распространяются по сети. Символы w(xm)n представляют веса связей между входом xm и нейроном n входного слоя. Символы yn представляют выходные сигналы нейрона n:

Далее, сигналы распространяются в скрытом слое. ....

...